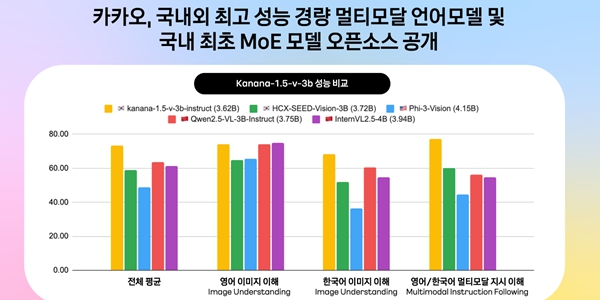

▲ 카나나-v, 국내외 모델과 비교 도표. <카카오>

카카오는 24일 허깅페이스를 통해 텍스트와 이미지 이해가 가능한 경량 멀티모달 모델 ‘카나나-1.5-v-3b’와 추론 효율성을 극대화한 전문가 혼합 모델 ‘카나나-1.5-15.7b-a3b’를 공개했다.

이는 지난 5월 카나나 1.5 언어모델 4종 공개 이후 약 두 달 만이다. 카카오가 정부가 추진하는 ‘독자 AI 파운데이션 모델 프로젝트’에 참여한 가운데 토대부터 개발한(프롬 스크래치) 방식으로 독자 모델 개발역량을 다시 한 번 입증했다고 회사는 설명했다.

이날 공개된 카나나-1.5-v-3b는 이미지 정보도 처리할 수 있는 멀티모달 언어모델이다.

이용자의 질문 의도를 정확히 이해하는 지시 이행 성능과 높은 한국어·영어 이미지 이해력을 보유했다. 특히 경량 구조임에도 GPT-4o와 견줄 만한 성능을 기록하며 한국어 벤치마크에서도 국내외 유사 사이즈의 공개모델들 사이에서 최고 점수를 받았다.

카카오는 고성능 대형 모델의 예측 패턴을 학습에 반영하는 ‘지식 증류’ 기법 등을 통해 모델 성능을 끌어올렸다.

함께 공개된 전문가 혼합 모델은 특정 작업에 최적화된 전문가 레이어 일부만을 활성화하는 방식으로 컴퓨팅 자원을 효율적으로 활용하는 것이 특징이다.

카카오는 기존 자사 3B 모델을 기반으로 업사이클링 기법을 적용해 15.7B 규모의 MoE 모델을 효율적으로 구축했다. 이 모델은 추론 시 약 3B 파라미터만을 사용하면서도 8B 모델 수준의 성능을 기록했다.

고성능 AI 인프라를 저비용으로 구축하고자 하는 기업과 연구자들에게 실용적인 도움을 제공할 것으로 기대된다.

카카오는 이번 공개를 통해 AI 모델의 고도화와 함께 국내 AI 생태계 강화에 기여하겠다는 방침이다.

앞으로 멀티모달 이해, 사용자 지시 수행, 추론능력을 강화하고 하반기에는 에이전트형 AI 개발에 필수적인 추론 모델의 성과도 공개한다.

김병학 카카오 카나나 성과리더는 “이번 공개는 비용 효율성과 성능을 동시에 충족시키는 의미 있는 결과”라며 “서비스 적용과 기술 자립이라는 두 가지 목표에 모두 부합하는 모델”이라고 말했다. 정희경 기자

![[조원씨앤아이] 서울시장 양자대결, 정원오 47.5% vs 오세훈 33.3%](https://businesspost.co.kr/news/photo/202601/20260127153647_266497.png)

![[단독] 네이버 사우디에서 '루키2'로 로봇배송 상용화 실험, 최수연 한국 도시 적용 완성도 높인다](https://businesspost.co.kr/news/photo/202602/20260211160952_174018.jpg)

![[코스피 5천 그늘③] CJ그룹 식품·물류·콘텐츠 투자매력 희미, 이재현 주가 부양 카드 언제 꺼내나](https://businesspost.co.kr/news/photo/202508/20250827144344_200101.jpg)